1. Définition

Commençons par rappeler quelques bases sur le son.

Une onde sonore est une propagation de vibrations mécaniques ; les molécules vibrent de part et d'autre de leur position moyenne, de proche en proche. Il en résulte des variations locales de pression dans tout l'espace traversé par l'onde sonore. Le son n'est donc qu'une succession de compressions et de dépressions locales et ne peut exister qu'en présence d'un émetteur et d'un récepteur. En outre, le son a besoin d'un milieu matériel (air, eau, acier, etc.) pour se propager et par conséquent, ne peut pas se propager dans le vide.

Dans les milieux liquides ou solides, le mécanisme de propagation du son est identique, seules les amplitudes de déplacement des molécules sont différentes. À titre d'information, la vitesse du son dans l'air est de 340 m/s, dans l'eau : 1500 m/s, dans l'acier : 5200 m/s.

L'oreille est capable de mesurer des écarts de pression infimes, de l'ordre de 2.10-5 Pa (à titre de comparaison, la pression atmosphérique normale varie autour de 1013 hPa). La pression acoustique de 2.10-5 Pa, seuil de l'audition, correspond à un son de 0 dB.

Un son est caractérisé par plusieurs choses :

-Son intensité, autrement dit son volume, qui correspond à l'amplitude de l'onde sonore. C'est la quantité d'énergie transportée par l'onde par unité de temps et de surface. On parle aussi de puissance acoustique ;

-Son niveau acoustique ou pression acoustique (qui s'exprime en décibels, dB) décrit l'amplitude du son perçu ; il dépend de la distance source-récepteur. Conversation normale : 60 dB ; seuil de douleur : 130-140 dB ;

-Sa hauteur dépend de la fréquence, elle définit si un son est perçu comme aigu ou grave. Plus le son est grave, plus la fréquence est basse ; plus il est aigu, plus sa fréquence est élevée.

-Son timbre ou tonalité est spécifique de la source sonore ; il permet de différencier deux sons de même fréquence et de même intensité. Par exemple, deux instruments différents peuvent jouer la même note, mais pourtant nous entendons deux sons différents.

Pour rappel, la gamme de fréquences audibles pour l'oreille humaine s'étend de 20 Hz à 20 kHz (en théorie, car tout dépend du sujet, de son âge et de ses capacités auditives...).

2. La numérisation

La numérisation du son consiste à le convertir en données numériques, pouvant être interprétées par un dispositif informatique. Elle comporte au moins 3 étapes : 1) l'échantillonnage, 2) la quantification et 3) l'encodage.

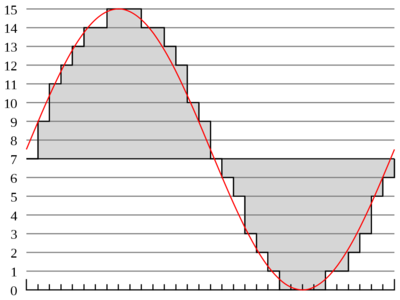

Pour commencer, le récepteur (un microphone) transforme le son en signal électrique et celui-ci est échantillonné, autrement dit, sa valeur est mesurée à des intervalles de temps précis. L'intervalle de temps entre deux échantillons est appelé le taux d'échantillonnage.

À savoir que les taux d'échantillonnage ne sont pas fixés de façon arbitraire. En effet, la conversion des signaux analogiques est basée sur un théorème dit de Nyquist-Shannon [2] , selon lequel, pour assurer une restitution correcte du son, la fréquence d'échantillonnage minimale théorique doit être au minimum égale au double de la fréquence maximale du signal initial.

Or, étant donné que le spectre audible s'étend de 20 Hz à 20 kHz, la fréquence d'échantillonnage sera d'au moins 40 kHz (44,1 kHz dans le cas d'un CD audio précisément, autrement dit la valeur de chacun des canaux est enregistrée 44100 fois par seconde).

Si la fréquence d'échantillonnage est trop faible, les valeurs relevées sont trop espacées et des détails pertinents pourraient être perdus. D'un autre côté, plus la fréquence d'échantillonnage est élevée, plus le résultat est fidèle à l'onde de départ, mais plus il requiert de puissance de traitement et d'espace de stockage...

L'étape d'échantillonnage effectuée, chaque échantillon est quantifié, autrement dit on lui attribue une valeur (binaire) qui se rapproche le plus de l'amplitude du signal initial (analogique) à cet instant. Pour cela, on doit choisir une échelle de mesure, sur laquelle l'échantillon ne pourra prendre que la valeur la plus proche (il n'y a pas de graduation intermédiaire en quelque sorte). Ainsi, plus le nombre de divisions de cette échelle est important, plus précise est la mesure, plus fidèle au signal initial sera le signal numérique.

Nous sommes en mode binaire. Ainsi, si on choisit de coder le signal sur un seul bit, il ne peut prendre que deux valeurs, 0 ou 1. Si on code sur 2 bits, on se retrouve avec 4 valeurs possibles, etc. Le nombre de bits désigne la profondeur de codage de l'échantillon. Dans le cas du CD audio, on (= Phillips et Sony) a opté pour une quantification sur 16 bits, donc 216 niveaux de quantification, soit 65536 valeurs possibles pour représenter les variations de l'intensité du son.

Pour désigner ce processus général de numérisation du son, qui consiste à échantillonner puis quantifier le signal analogique, on parle de PCM pour Pulse Code Modulation, soit modulation d'impulsion codée en français.

Enfin, outre sa fréquence d'échantillonnage et sa profondeur de codage, un son numérique est également caractérisé par le nombre de voies utilisées (1 = son mono, 2 = son stéréo...).

3. La compression audio

Si vous décidez d'extraire les différents titres d'un CD audio, histoire de les écouter sur votre smartphone ou votre baladeur numérique, vous obtiendrez une série de fichiers audio au format (conteneur) WAV (le flux audio est non compressé, encodé en PCM). Ce format, créé par Microsoft et IBM, n'est toutefois pas très pratique : système de tags rudimentaire, fichiers relativement lourds, ... Les formats audio compressés sont nés de ce besoin.

Le format des données d'un CD audio respecte le standard Compact Disc Digital Audio (CDDA), défini dans le Red Book (qui contient toutes les spécifications techniques des formats de CD), édité pour la première fois en 1980 par Sony et Philips. Il s'agit d’une piste stéréo, encodée en PCM (Pulse Code Modulation) à une résolution de 16 bits, avec une fréquence d’échantillonnage de 44,1 kHz.

Ils reposent sur le principe suivant : on retire du signal audio tout ce qui est considéré comme « inutile » (tout ce que l'oreille humaine ne peut entendre). Ainsi, un fichier audio encodé en MP3 est dix fois plus léger que le même fichier au format WAV et ce, sans entraîner de perte notable de qualité.

3.1 Les différentes techniques de compression

On distingue principalement deux types de compression.

Certaines techniques sont dites destructrices (ou lossy). Autrement dit, si l'on décompresse le signal ainsi compressé, le fichier résultant ne ressemblera pas exactement au signal d'origine. En effet, une compression destructrice repose sur le principe suivant : on retire du signal tout ce qui est considéré comme inutile car inaudible par l'oreille humaine (les fréquences pas ou peu audibles du spectre sonore et certains silences). Le signal audio compressé s'avère de ce fait beaucoup plus léger que le fichier d'origine (mais il faut garder à l'esprit qu'on lui a quand même retiré certaines informations, même si cela ne gâche en rien l'écoute...).

Les techniques dites non destructrices (ou lossless) reposent quant à elles sur des méthodes particulières de codage. Comme vous le savez, un son n'est rien d'autre qu'une succession de fréquences. Eh bien, considérons par exemple que dans la suite d'échantillons qui composent 1 seconde de musique on trouve 10 fois de suite la même fréquence. Une compression non destructrice consiste alors à coder, non pas 10 points, mais un seul point suivi du nombre de fois où il se répète, ce qui nous donne 2 nombres à coder au lieu de 10. Et si l'on applique cette même méthode non pas à des fréquences identiques mais vraiment très proches (si proches qu'il est impossible à l'oreille humaine de les distinguer), on gagne encore de la place.

Nous sommes donc bien en présence d'une compression non destructrice, aussi appelée « sans pertes », car les fréquences ne sont pas supprimées, mais simplement codées de manière différente. Toutefois, ces techniques permettent évidemment un moindre gain de place que les techniques destructrices.

Le niveau de compression peut être plus ou moins important ; il est défini par le débit binaire, autrement dit le flux d'informations par seconde de musique, qui s'exprime en kb/s (pour kilobits par seconde). Un débit de 32 kb/s génère un son plutôt médiocre, de type grandes ondes radio ; on considère aujourd'hui qu'il faut au moins un débit de 192 kb/s pour bénéficier d'une qualité audio acceptable pour un morceau de musique numérique.

Il existe plusieurs outils de compression audio, regroupés sous le terme codecs (des mots « codage » et « décodage »).

Pour connaître les caractéristiques d'un fichier audio, vous pouvez au choix afficher ses propriétés dans le lecteur de musique que vous utilisez habituellement (ils le proposent quasiment tous), ou bien vous pouvez utiliser la commande ffmpeg -i, suivie du nom du fichier, qui vous retournera ses métadonnées, mais aussi les caractéristiques du flux audio.

3.2 Les principaux codecs audio

3.2.1 MP3

Le format MP3, abréviation de MPEG-1/2 Audio Layer 3, est un format de compression de type destructeur (lossy). Publié en 1993 par le Moving Picture Experts Group (MPEG), c'est aujourd'hui le format audio numérique le plus utilisé aujourd'hui, notamment pour le stockage des fichiers (sur baladeurs, smartphones, ou tout autre appareil multimédia) et pour le streaming. Le gros avantage du MP3 réside en effet dans sa large compatibilité avec l'ensemble du matériel audio-numérique actuellement sur le marché.

Son algorithme de compression permet de réduire grandement la taille du fichier d'origine (rapport pouvant aller jusqu'à 1:11 en moyenne à un débit de 128 kb/s), car il supprime de nombreuses données de l'enregistrement. Seules les ouïes les plus fines percevront une différence, mais ce n'est pas audible dans la plupart des cas (les pertes d'informations étant notamment masquées par la moindre qualité du matériel audio utilisé, comme les oreillettes de votre baladeur par exemple). On privilégiera toutefois un débit de l'ordre de 192 kb/s, voire 320 kb/s pour une meilleure restitution du flux audio.

Attention, la qualité d'un fichier audio compressé dépend également des options passées au programme d'encodage, pas seulement du programme en lui-même ! Lisez attentivement la page de manuel de l'encodeur pour prendre connaissance de l'ensemble des options disponibles...

Parmi les encodeurs MP3 libres les plus utilisés, on peut citer le programme lame, qui se trouve dans les dépôts de la plupart des distributions Linux (pas toujours dans les dépôts principaux toutefois, il vous faudra parfois chercher dans les dépôts dédiés au multimédia ou les dépôts « complémentaires » de type universe chez Ubuntu, ou RPM Fusion chez Fedora/Red Hat...).

La manière la plus simple et la plus rapide d'encoder en MP3 est d'utiliser un débit constant (Constant Bit Rate ou CBR) pour l'ensemble du morceau de musique. Cependant, il est possible, avec certains programmes d'encodage, de faire varier le débit lors du processus ; on parle alors de débit variable (Variable Bit Rate ou VBR). Par exemple, pour tous les passages moins « complexes », comme les silences ou les passages où l'on entend que peu d'instruments, on utilisera un débit plus bas ; parallèlement, pour les passages plus riches en informations, on utilisera un haut débit. Le fichier résultant sera ainsi de bien meilleure qualité.

3.2.2 AAC

L'Advanced Audio Coding ou AAC est un algorithme de compression audio avec pertes, conçu en 1997 par un consortium au sein duquel on trouve l'institut Fraunhofer (concepteur du MP3), AT&T, Sony et Dolby. Depuis, le format a évolué et a été rebaptisé au passage au fil des versions : AAC+, eAAC+, HD-AAC.

Conçu pour proposer un meilleur rapport qualité/débit que le MP3, il permet ainsi une meilleure qualité d'audition à des débits moindres. En outre, il supporte jusqu'à 48 canaux, tandis que le MP3 ne supporte que 2 canaux (stéréo) en mode MPEG-1 et jusqu'à 5.1 canaux en MPEG-2. Ce format adopte une approche « modulaire » ; en effet, différents profils d'encodage existent (AAC-LC, ER-AAC-LD, AAC-LC + SBR, etc.) selon la complexité du flux audio et la qualité visée.

L'AAC est le format audio privilégié d'Apple, il est donc parfaitement pris en charge par le matériel Apple et le logiciel iTunes. L’extension de fichier généralement adoptée est .mp4 (car il s'appuie sur le MPEG-4) ou .aac.L'encodeur que l'on utilisera sous Linux pour le format AAC est faac.

Ajouter à une liste de lecture

Ajouter à une liste de lecture